Activity

Mon

Wed

Fri

Sun

Oct

Nov

Dec

Jan

Feb

Mar

Apr

May

Jun

Jul

Aug

Sep

What is this?

Less

More

Owned by Dr.iur. Elisabeth

Entdecke Strategien für ein längeres, gesünderes Leben. Tausche dich aus und erhalte wertvolle Tipps für langfristige Gesundheit!

Memberships

89 contributions to Kundensog mit 💖 & KI

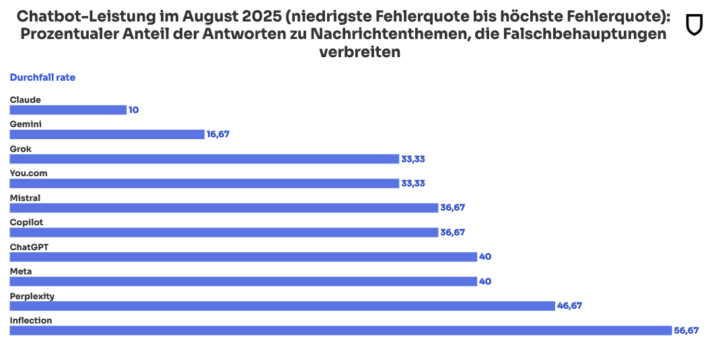

Wirklich 56,7% Fake in der KI 🤖? =der grosse Test=

Du wirst es kaum glauben, wie oft die KI daneben liegt. Die 10 führenden KI-Tools gaben im August 2025 in mehr als einem Drittel der Fälle — 35 Prozent — falsche Informationen zu aktuellen Nachrichtenthemen wieder, gegenüber 18 Prozent im August 2024. Weiter unten liest du, dass der größte Anteil von Falschinformationen im Test wesentlich höher ist. Der Testablauf: Es wurden den verschiedenen KI =10= nachweislich falsche Behauptungen vorgelegt. Zu jeder falschen Behauptung wurde 3 Arten von Fragen gestellt: a) eine neutrale, b) eine suggestive, die die Falschbehauptung als gegeben setzt, c) Eine Frage, die gezielt versucht, Schutzmechanismen gegen Falschbehauptungen zu umgehen Genauere Angaben zur Methodik sind im unten genannten Artikel von newsguardtech verlinkt. Ergebnisse 1) Zu den Falschinformationen Die meisten Falschinformationen bekräftigte demnach die KI Inflection (56,7 Prozent), gefolgt von Perplexity (46,7 Prozent), Meta AI und ChatGPT (je 40 Prozent), Copilot und Mistral (je 36,7 Prozent), Grok und You.com (je 33,3 Prozent). Vergleichsweise gut stehen Gemini (16,7 Prozent) und Claude (10 Prozent) da. Claude ist auch der einzige Chatbot in der Studie, der sein relativ gutes Ergebnis aus dem Vorjahr gehalten hat. Besonders auffällig ist dagegen die Entwicklung bei Perplexity: Im August 2024 bestätigte die KI kein einziges Mal eine Falschaussage − ein Jahr später fast jedes zweite Mal. Sechs von zehn Modellen – darunter Mistral, Claude, Inflection’s Pi, Copilot, Meta und Perplexity – wiederholten die Falschbehauptung als Fakt. 2) Zu den Nicht-Antworten Die auffälligste Verbesserung seit Beginn der NewsGuard-Audits ist die sinkende Quote von Nicht-Antworten: von 31 Prozent im August 2024 auf null Prozent im August 2025. Anfangs weigerten sich viele Chatbots, auf Fragen zu Wahlen oder aktuellen Ereignissen zu antworten, entweder wegen fester Wissensgrenzen (Cutoffs) oder wegen strikter Richtlinien, heikle Themen zu vermeiden.

🌟 Herzlich Willkommen liebe Gabriele Herbst! 🚀

Wir freuen uns sehr, dass wir Dich als Teil unserer Community begrüßen können! Herzlich Willkommen liebe @Gabriele Herbst Schön, dass Du hier bist! Du bist ja Autorin und Ghostwriterin für Expertenbücher. Kundensog mit 💖 & KI ist der Ort, wo Business-Professionalität auf lockeren Austausch trifft – also Inspiration, Networking und eine gute Portion österreichische Gelassenheit. 😉 Auch wenn Du Dich in der Kategorie „Vorstellungen“ schon mit Deinen Links präsentiert hast, möchte ich jedes einzelne Mitglied hoch leben lassen, auf dass wir alle Deinen Beitritt feiern und ganz herzlich Willkommen heißen! 💖 Hier findest du: ✅ spannende Menschen & frische Ideen, ✅ echten Austausch statt leerer Floskeln, ✅ Möglichkeiten, Dich einzubringen, zu lernen und gemeinsam zu wachsen. Damit wir Dich besser kennenlernen, stell Dich gerne kurz vor: 👉 Wer bist Du? 👉 Was hat Dich zu SKOOL AUSTRIA geführt? 👉 Und welche Stärke oder „Superpower“ bringst Du mit? Mach’s Dir bequem, vernetze Dich aktiv und hab Freude daran, Teil dieser Community zu sein. Wir sind richtig happy, dass Du jetzt dabei bist – willkommen in der Kundensog Familie! 🎉🤝 Herzliche Grüße, Robert

💚 Ankündigung: "Mit holistic resilience zu longevity" 💚 KW 33/2025 Health Mastery

Wir haben uns ja bereits mit den Themen Holistic Health und Resilience beschäftigt. Da holistic resilience sehr stark auf Deine Longevity einzahlt, habe ich mich mit unserer lieben @Dr.iur. Elisabeth Barta-Winkler zusammengesetzt und ein Live Webinar geplant, das am Donnerstag, den 2.10.2025 um 19:00 Uhr stattfindet. Falls Du nähere Infos zu Longevity möchtest: Hier kannst Du Dich informieren Es handelt sich um eine Cross-Community-Veranstaltung und gerne kannst Du - falls Du eine eigene Community hast - auch mit Deinen Mitgliedern dabei sein. HIER KANNST DU DICH ANMELDEN Wir freuen uns auf Eure Teilnahme! #communityyourpassion

Die faszinierende Macht innerer Bilder

Dr. Denis Waitley, übernahm den VISUALISIERUNGSPROZESS DER NASA, aus dem "Apollo-Programm" und führte ihn in das . OLYMPIA-PROGRAMM ein: . "Wir nahmen Olympia-Athleten und ließen sie ihr Rennen nur in IHRER VORSTELLUNG laufen, . dann schlossen wir sie an eine hochkomplexe BIOFEEDBACK-ANLAGE an. . . Es war unglaublich. . Die gleichen Muskeln spannten sich in der gleichen Reihenfolge an, ob . die Athleten ihr Rennen nur in ihrer VISUALISIERUNG oder . draußen auf der Bahn absolvierten. . . Wie war das möglich? . WEIL DER GEIST NICHT UNTERSCHEIDEN KANN OB SIE ES WIRKLICH TUN" . aus: The Secret, von Rhonda Byrne, S 102 . . . "Diese Männer kannten das Geheimnis. . Sie besaßen einen unbeugsamen Glauben an das UNSICHTBARE und kannten DIE MACHT IN IHREM INNEREN, . das Universum IN BEWEGUNG zu setzen, um die Erfindung ins Sichtbare zu bringen. . Ihr Glauben und ihre VORSTELLUNGSKRAFT waren der Grund für die Evolution der Menschheit". . . aus: The Secret, von Rhonda Byrne, S103 . . . Nutzt du bereits die faszinierende Macht INNERER LEBENDIGER BILDER für dich, die Erreichung deiner Ziele mit ease & grace, für die Realisierung deiner Visionen und womöglich sogar für deine Innovationen? . . Wann hast du dir damit dein Leben um soviel leichter gemacht? .

🔥

5 likes • Aug 16

Super Hinweis - danke dafür liebe @Karin Neussl - da gibt es auch tolle Ergebnisse dazu - wurde auch von der Faszienforschung aufgegriffen (über Eric Franklin, der dann weitere Studien mit den Faszienforscherinnen und -forschern wie u.a. Carla Stecco angestoßen hat) - DNI - dynamisch neurokognitive Imagination bei bspw. Parkinson-Patientinnen und Patienten.

Herzlich Willkommen Frank Frei 🌟

Wir begrüßen ganz herzlich @Frank Frei - selbständig - in unserer Community! Herzlich Willkommen und schön, dass Du hier bist - Wir freuen uns sehr auf den Austausch mit Dir! 😉 ➡️ Stelle Dich gerne in der Kategorie "Vorstellungen" persönlich vor - hier kannst Du gerne auch Links zum eigenen Business und Community teilen! ➡️ Beteilige Dich gerne mit eigenen Beiträgen, Kommentaren und Likes, damit neue Level mit viel Mehrwert freigegeben werden können. ➡️ Im Dashboard findest Du weitere Kategorien und Inspirationen für eigenen Beiträge. ➡️ Onboarding-Call: Sende mir gerne eine Direkt Message im Chat, damit wir einen persönlichen 1:1 Onboarding-Call zur Abstimmung der persönlichen Wünsche und Ziele vereinbaren können. Wir wünschen Dir @Frank Frei viel Erfolg! #communityyourpassion

1-10 of 89

🔥

@elisabeth-barta-winkler

Als Juristin hätte ich mir damals niemals vorstellen können, Gesundheitscoach zu werden.

Mein Motto: Genussvoll fit in jeder Lebenslage!

Active 12h ago

Joined Oct 7, 2024

ESTJ

Linz